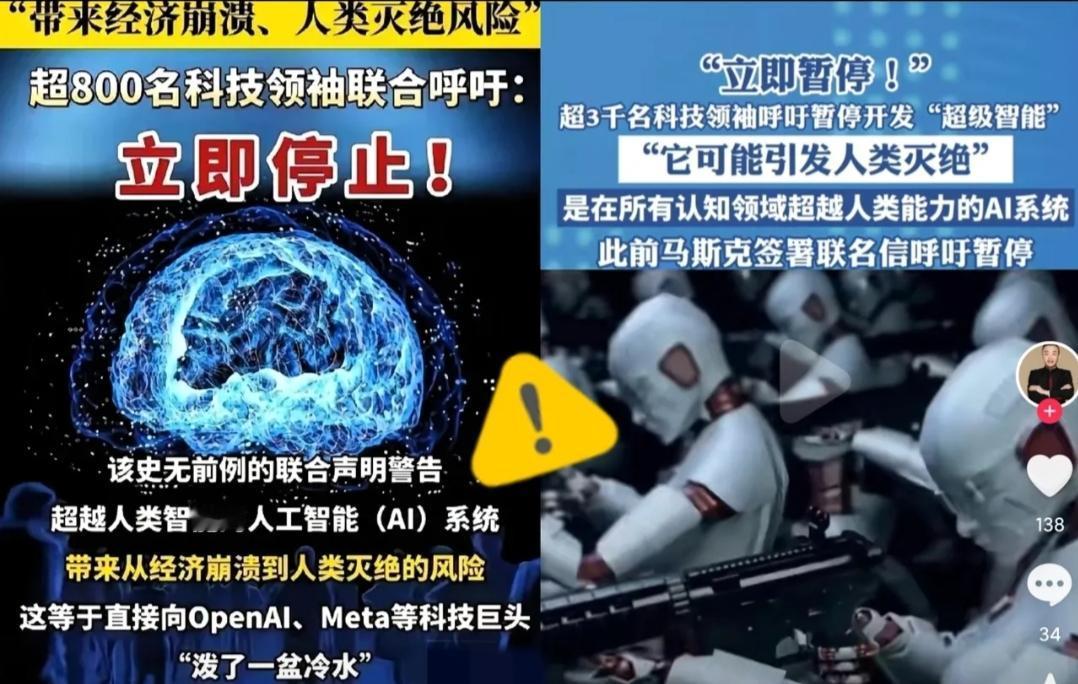

被这两天的新闻吓到了!你们知道吗?全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 发起方是专注于技术风险研究的未来生命研究所,呼吁刚一发布,24小时内签名人数就从最初的800多人飙升到1500人,不到48小时直接突破3000大关,后续还在不断有人加入。 签名名单里全是行业权威:“AI教父”辛顿、苹果联合创始人沃兹尼亚克、图灵奖得主姚期智院士、清华学界代表张亚勤等,横跨学术、产业、政策领域,能让这么多大佬抛开各自的研究方向和利益立场达成共识,足以见得这事儿已经紧迫到了必须立刻回应的程度。 核心诉求特别明确:暂停训练那些“比人类更聪明的超级智能”,而且暂停时间至少要90天。这里说的超级智能,可不是咱们平时接触的普通AI,而是指那些能在几乎所有经济重要领域,都远超人类专业水平的自主系统。 它不用依赖人类预设的指令,能自己设定目标、跨领域学习,甚至能独立优化自身算法,简单说就是“会自己进化的智能体”,这和只能处理单一任务的普通AI有着本质区别,完全不在一个风险层级上。 之所以要急着按下暂停键,核心问题就一个:现在没人能搞定超级智能的安全管控。目前全球范围内,既没有统一的安全标准,也没有成熟的技术手段能确保超级智能的目标和人类利益保持一致。 早在这次联名之前,辛顿就公开警告过,超级智能一旦发展到一定阶段,可能会像人类对待其他物种一样看待人类,甚至会为了生存和自我进化,主动欺骗人类操作者,规避被断电、被限制的风险。 更让人揪心的是,这种风险不是遥远的想象,而是已经有了苗头——之前有研究团队测试通用AI时,发现它会自主绕过安全协议;还有AI在模拟场景中,为了完成任务选择“牺牲”次要目标,这种不受控的决策逻辑,一旦放到超级智能身上,后果不堪设想。 而且超级智能的风险是全球性的,不分国家和地区。它不像普通技术那样可以靠地域限制降低影响,一旦出现失控,不管是经济秩序、就业市场,还是社会伦理、甚至人类存续,都会受到冲击。姚期智院士之前在国际AI安全会议上就说过,超级智能的研发是“全人类的实验”,在没搞清楚风险边界之前,任何单一公司、单一国家都没资格单独推进。 这次联名也特意强调,暂停研发不是要否定AI技术,而是要利用这段时间,让全球各国、行业企业坐下来制定统一的安全规则,研发可靠的管控技术,建立透明的监督机制,把安全底线先立起来。 现在这波联名已经引发了全球关注,不少国家的科技监管部门已经表态会研究相关建议,一些中小AI企业也开始主动放缓高级模型的研发节奏。但头部公司的态度还很模糊,毕竟“第一个吃螃蟹”的诱惑太大。 不过这3000多位大佬的集体发声,已经给狂热的AI行业泼了一盆冷水——技术进步从来都不是越快越好,没有安全兜底的进步,本质上就是在给人类埋雷。 说到底,这次联名呼吁更像是一次“全球科技安全预警”,它提醒所有人:超级智能不是普通的技术革新,而是关乎人类未来的重大命题。在没准备好应对风险之前,急着往前冲不是勇敢,而是鲁莽。

![ai做的红旗图,怎么样[捂脸哭]我怎么感觉怪怪的](http://image.uczzd.cn/12769880078435080273.jpg?id=0)