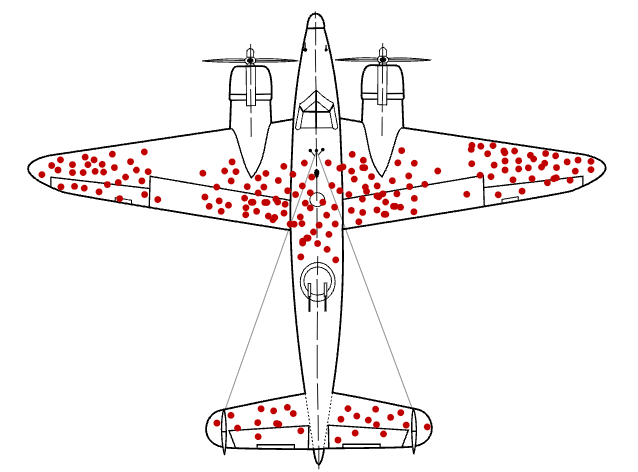

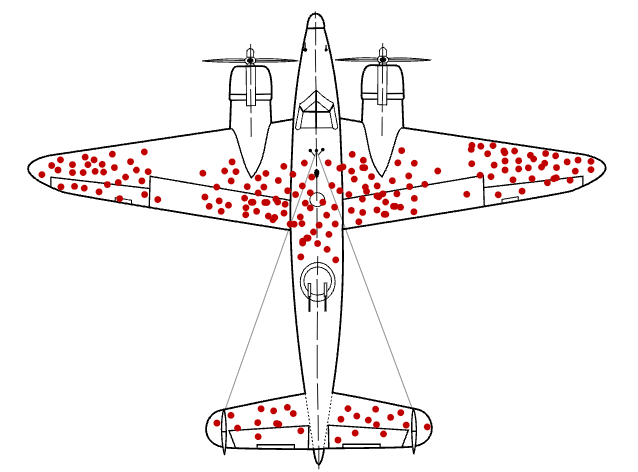

kalomaze.bearblog.dev/dont-exclude-rl-rollouts/一篇由开发者 Kalomaze 撰写的技术博文,针对大模型的强化学习提出了一个反直觉的观点:在构建用于训练推理模型的数据集时,不应随意剔除或清洗掉那些包含“试错、自我修正、甚至死胡同”的长思维链(RL Rollouts)。这些看似冗余或不完美的推理过程,恰恰是模型通过强化学习涌现出智能的关键特征。应该设计奖励信号来主动引导模型远离该行为。HOW I AI

kalomaze.bearblog.dev/dont-exclude-rl-rollouts/一篇由开发者 Kalomaze 撰写的技术博文,针对大模型的强化学习提出了一个反直觉的观点:在构建用于训练推理模型的数据集时,不应随意剔除或清洗掉那些包含“试错、自我修正、甚至死胡同”的长思维链(RL Rollouts)。这些看似冗余或不完美的推理过程,恰恰是模型通过强化学习涌现出智能的关键特征。应该设计奖励信号来主动引导模型远离该行为。HOW I AI

作者最新文章

热门分类

科技TOP

科技最新文章