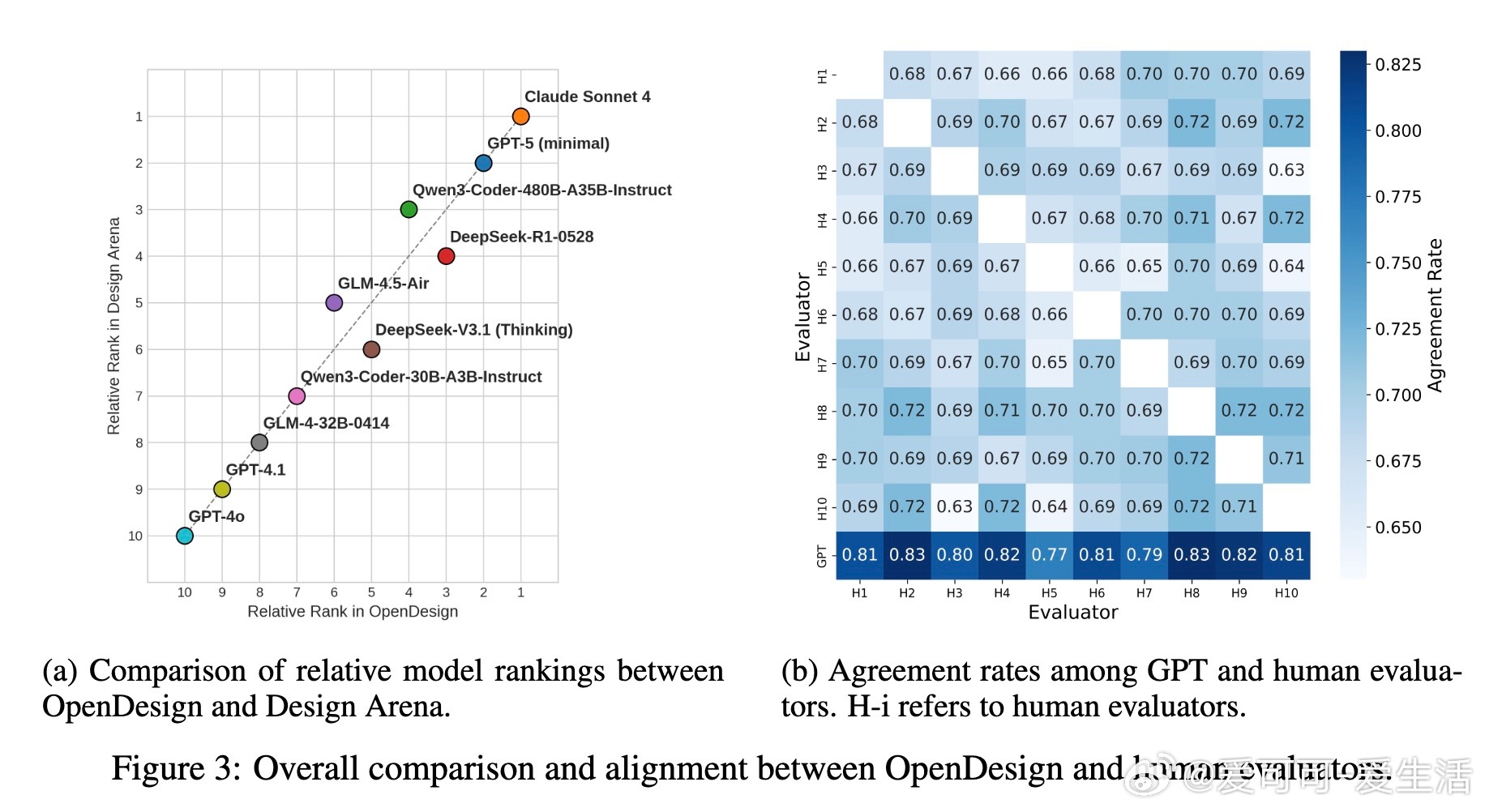

[CL]《Code Aesthetics with Agentic Reward Feedback》B Xiao, L Jiang, S Huang, T Lv... [Microsoft Research Asia] (2025)

代码美学新突破:Agentic Reward Feedback助力视觉代码生成

随着大型语言模型(LLMs)在代码生成领域的广泛应用,传统任务如代码生成、bug修复表现卓越,但在视觉导向的编程任务(如图表生成、网页设计)中,模型生成的代码往往美观度不足,存在元素重叠、配色不当和结构混乱等问题。本文提出并系统研究了“代码美学”概念,旨在提升LLMs生成视觉代码的美观与功能性。

核心贡献:

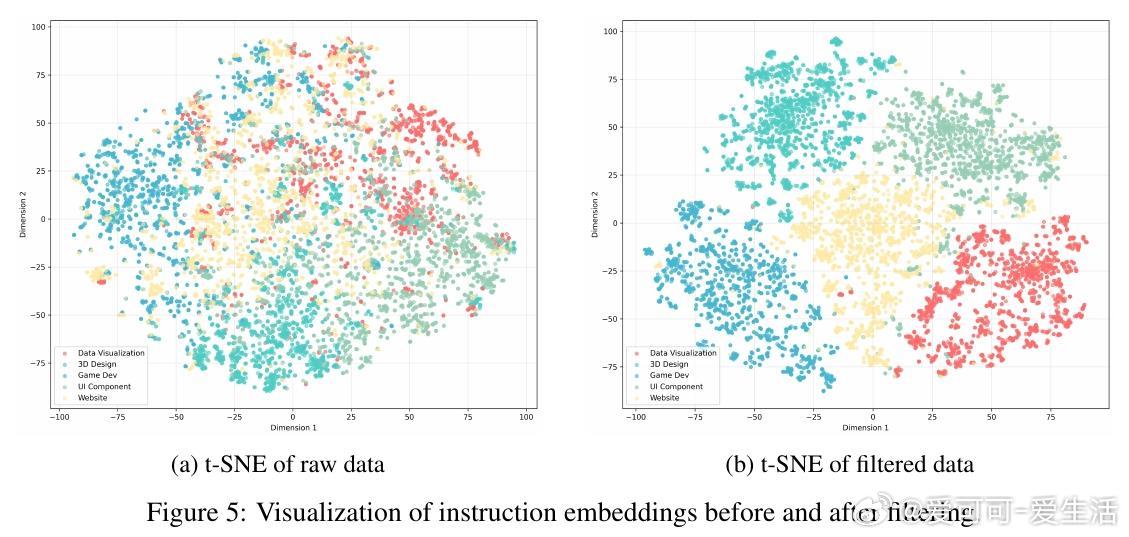

1. AesCode-358K数据集:首个大规模指令微调数据集,涵盖Python绘图与网页设计两大视觉编程领域,确保代码可执行且美观。

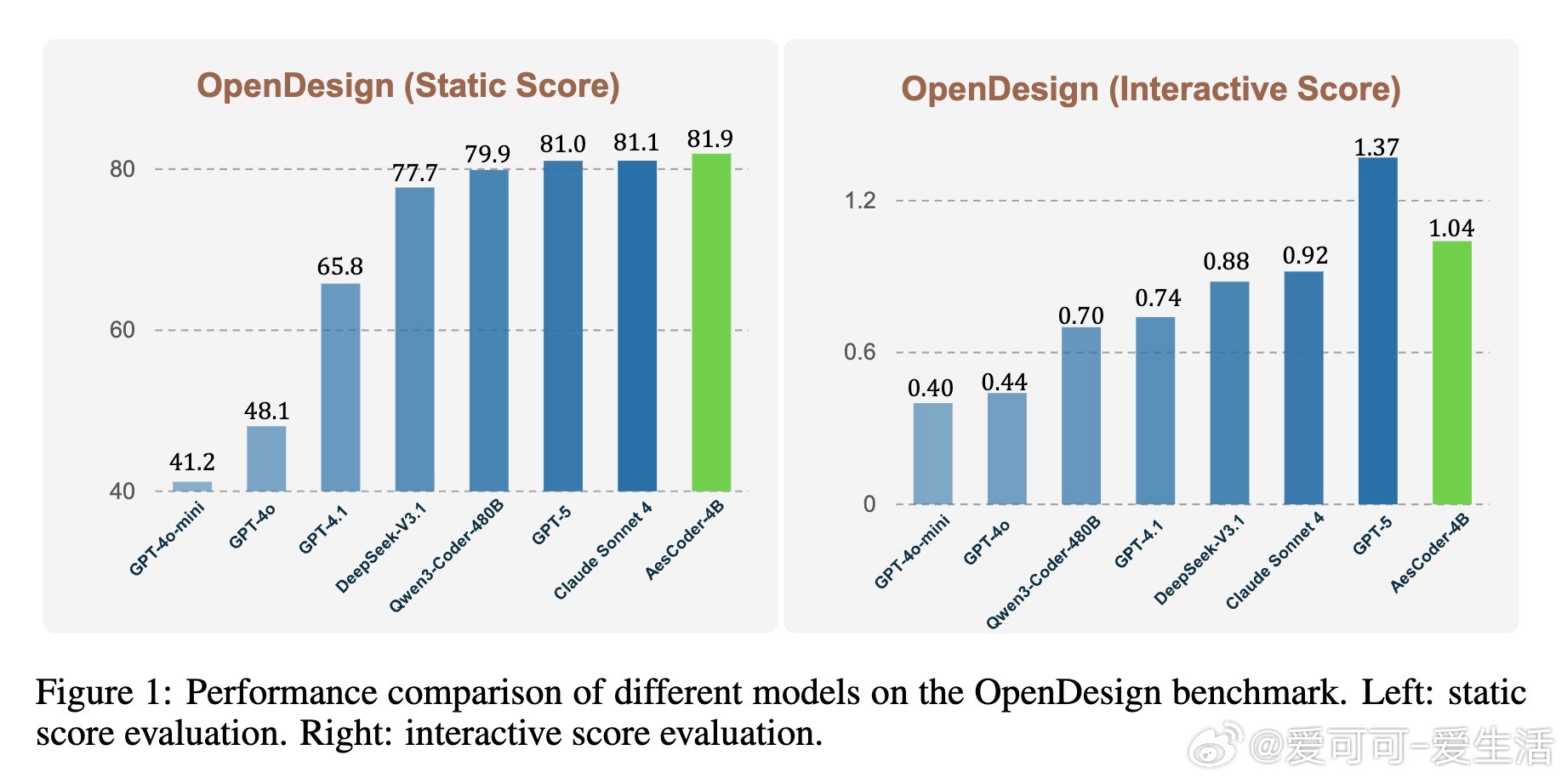

2. Agentic Reward反馈机制:引入多智能体系统,包括执行代理(检查代码可执行性)、静态美学代理(基于渲染截图评估视觉质量)、交互美学代理(模拟用户交互,评估网页交互性与美学)。三者结合,形成多维度综合奖励信号,突破传统单一文本奖励的限制。

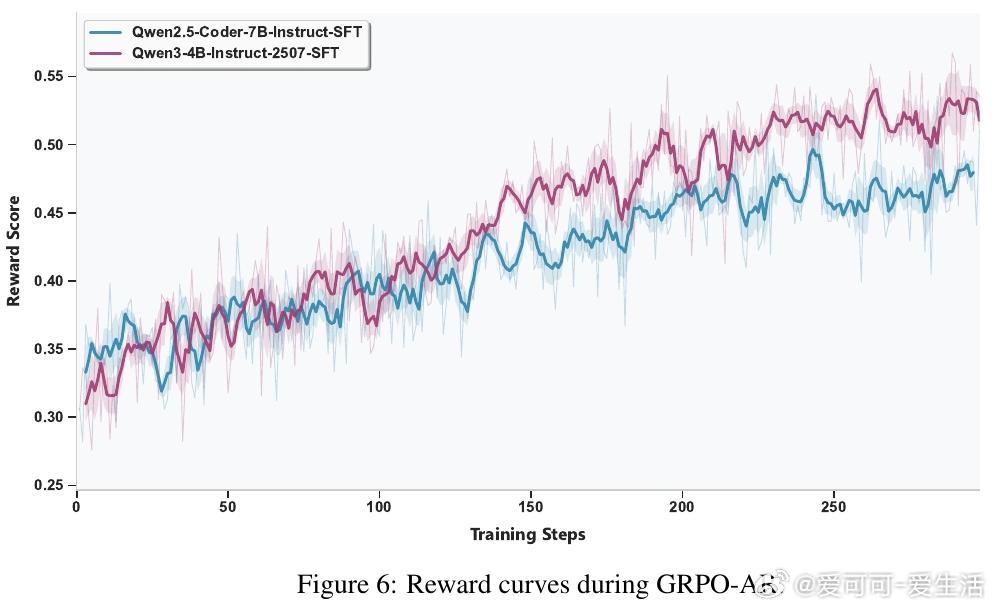

3. GRPO-AR训练算法:基于GRPO强化学习框架,结合agentic reward,联合优化代码的功能正确性与视觉美学,显著提升模型生成质量。

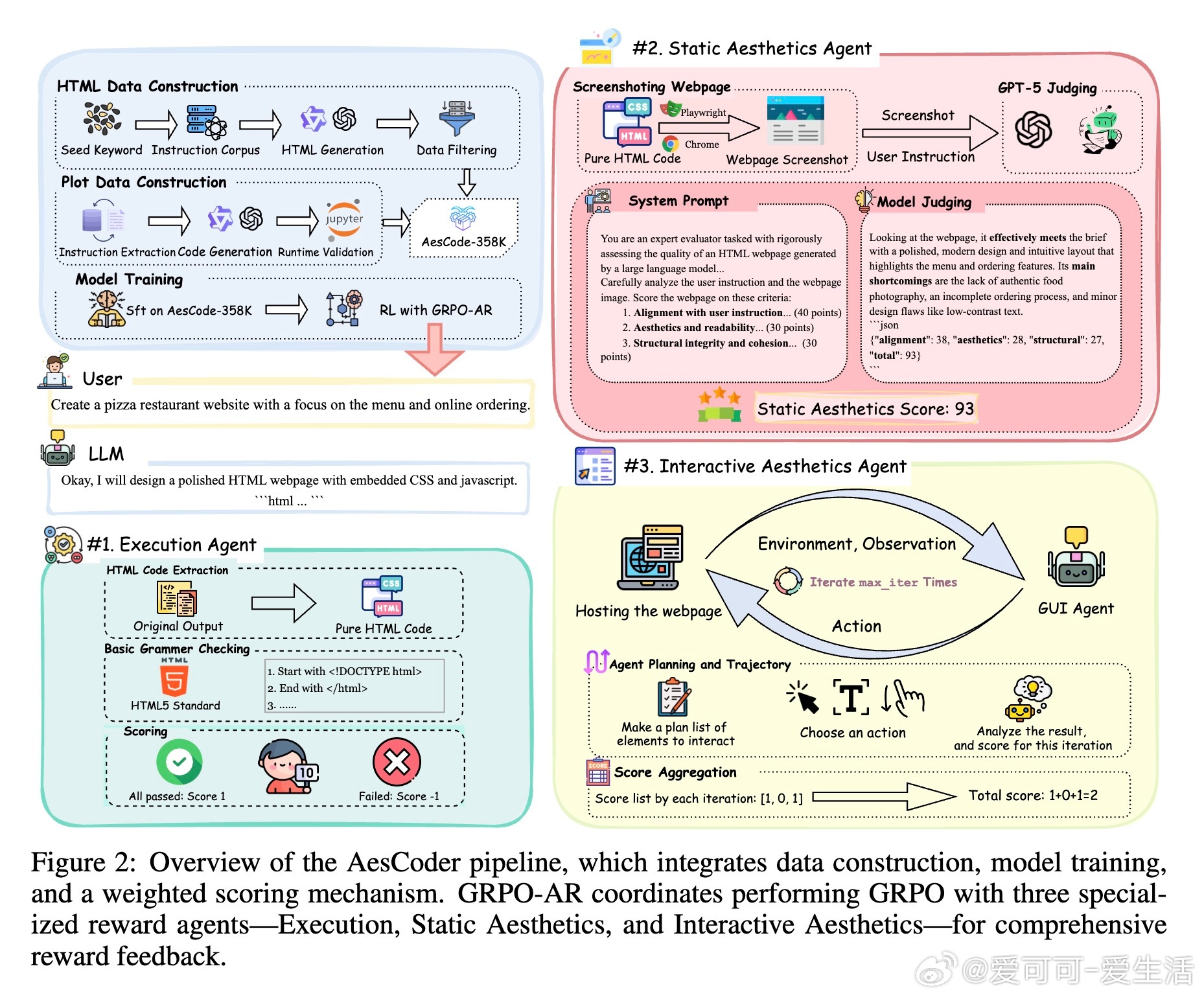

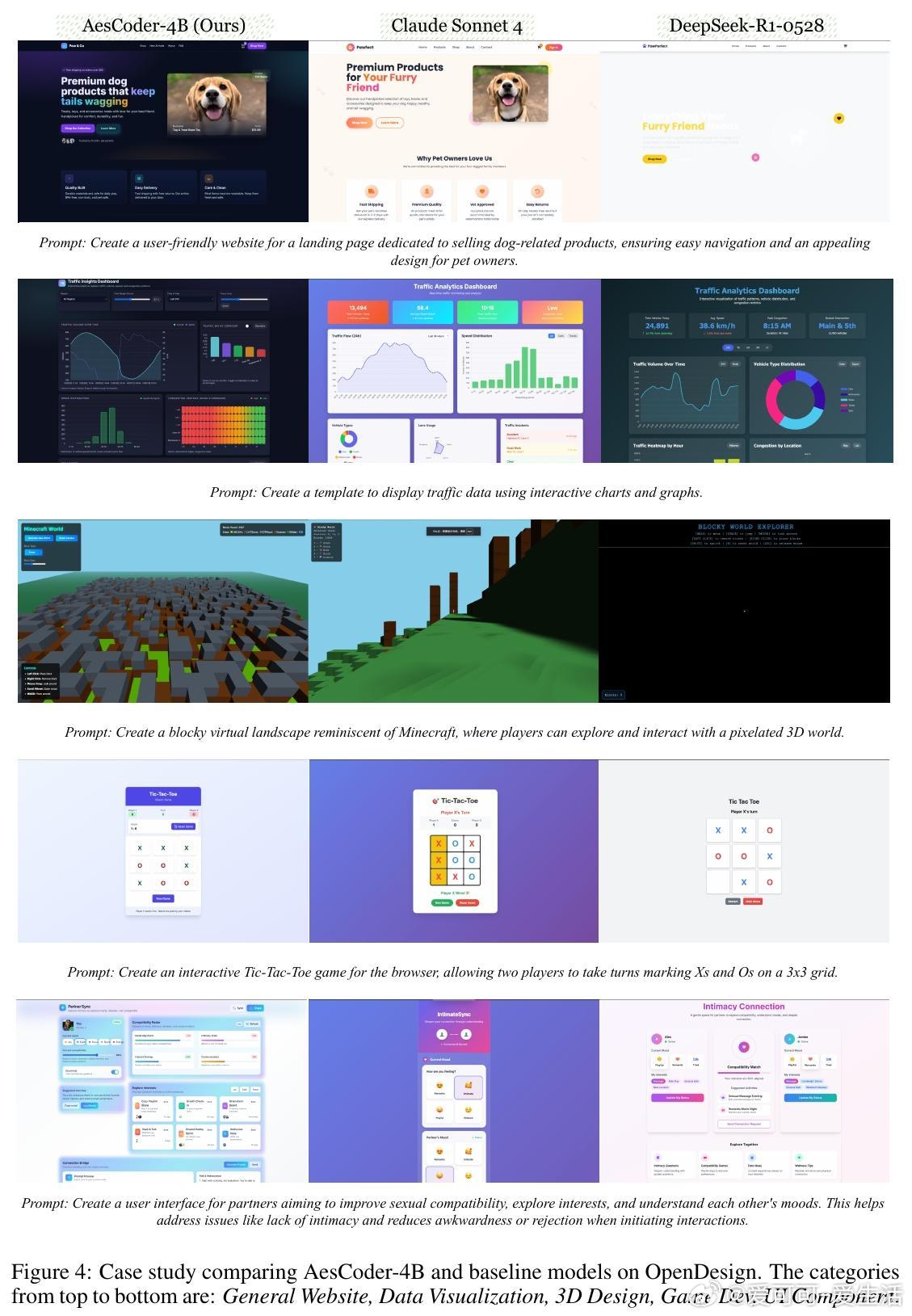

4. OpenDesign基准:首个自动化网页设计美学评测基准,涵盖840个真实网页设计案例,支持静态和交互美学双维度评测,LLM作为评审与人类评分高度一致,验证评测可靠性。

实验亮点:

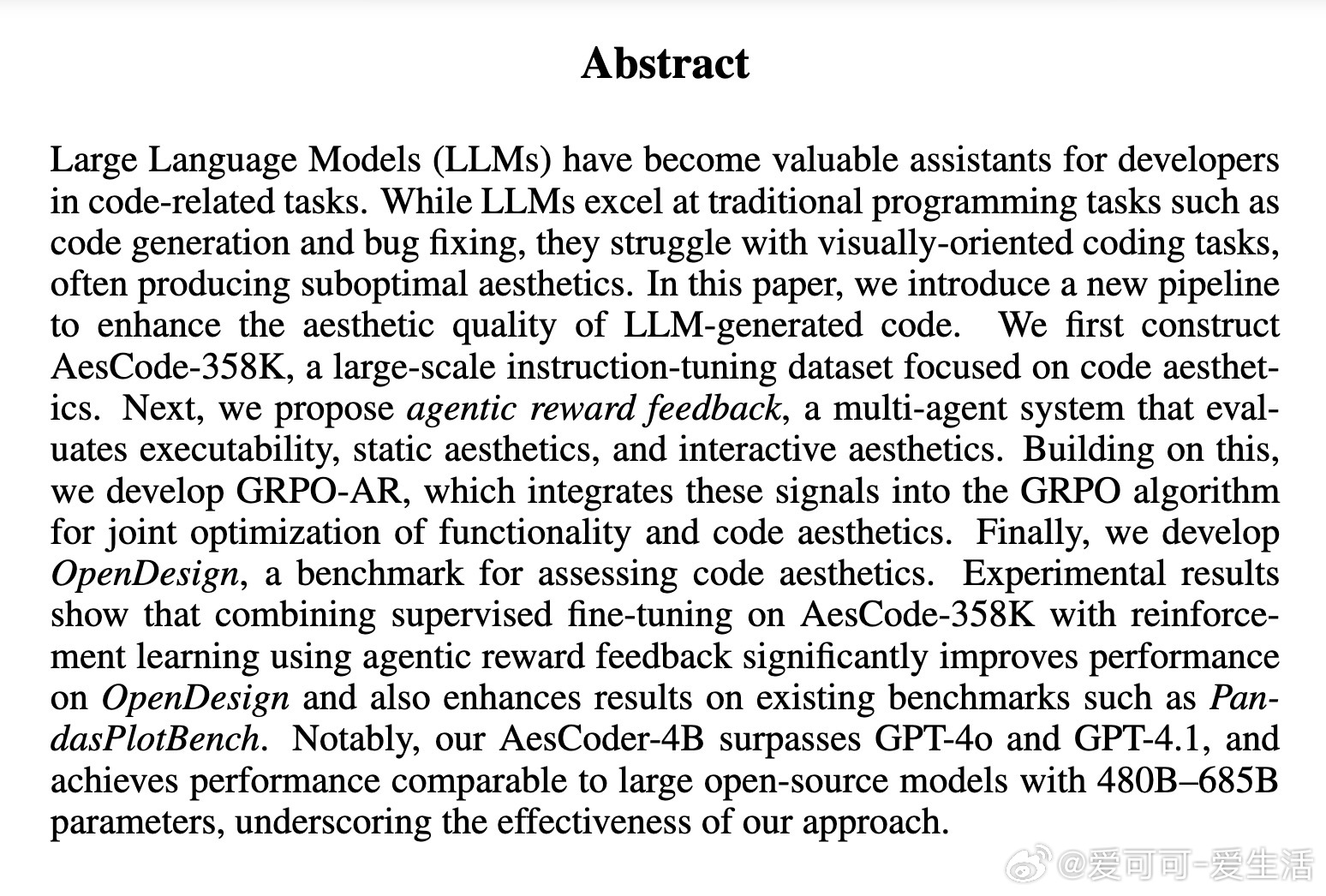

- AesCoder-4B模型在OpenDesign和PandasPlotBench两大基准中表现优异,超越GPT-4o、GPT-4.1,并接近数百亿参数大模型水平。

- 结合监督微调与GRPO-AR强化学习,模型在代码执行率、视觉对齐度、结构合理性及交互体验均有显著提升。

- 多智能体奖励系统稳定提供有效反馈,促进模型泛化能力和代码美学感知。

- 人类评测与LLM评审高度一致,支持LLM-as-a-Judge方法在美学评估中的可行性。

意义与前景:

本研究首次系统定义并实证了代码美学的训练与评测体系,为视觉导向的代码生成任务注入新的活力。Agentic Reward Feedback框架通过多维度评价,不仅保证代码功能正确,更兼顾视觉和交互体验,推动开发者辅助工具向更人性化、美观化方向发展。未来,该框架有望拓展至更多多模态交互式编程任务,提升AI在设计与开发领域的综合能力。

详细阅读与项目地址:

arxiv.org/abs/2510.23272

项目主页:bangx7.github.io/code-aesthetics