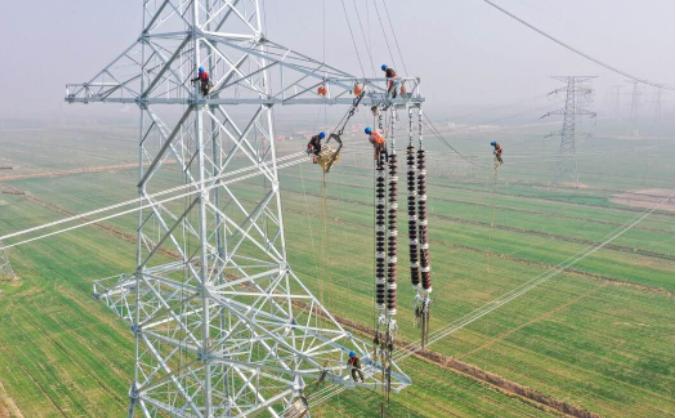

AI的发动机是什么?是算力。而作为算力载体的数据中心,是一个个用电量堪比小城市的巨型铁盒子。随着GPU功耗一代比一代高,马斯克说未来会缺电,这不是贩卖焦虑,这是陈述事实。 你想啊,十年前的电脑主机开一天也耗不了几度电,可现在支撑AI的服务器完全是另一个量级。 英伟达那AI服务器,才八年时间,功耗就涨了100倍,以前一个机架也就1.2千瓦的耗电,现在最新的机型直接飙到140千瓦,比普通家庭一年的用电量还多。 更吓人的是,单个超大规模数据中心的耗电量能达到1吉瓦,这是什么概念?相当于100万户美国家庭的用电需求,比不少小城市的总用电量还高。 马斯克早就说了,两年内咱们会从“缺芯片”变成“缺电”,这真不是危言耸听,他自己旗下公司训练的模型,因为当地电网扛不住,硬生生启用了35台燃气涡轮机临时供电,还闹出了污染超标旳麻烦。 可能有人会说,用电多就多搞点光伏、风电呗?这话听着在理,可实际用起来根本靠不住。光伏白天有太阳才发电,晚上就歇菜;风电更看天脸色,没风的时候机器就是个摆设。 但数据中心的机器不能停啊,AI训练一旦中断,前面的功夫全白费,这就需要一种能24小时连轴转、出力稳当的能源。 放眼所有清洁能源,只有核电能担这担子,核电的年利用小时数能超过7500小时,也就是说一年里差不多90%的时间都在稳定发电,反观光伏也就1200小时,风电刚到2200小时,根本没法比。 而且核电的发电效率还高,成本也可控,燃料费只占总成本的30%,不像火电那样被煤价折腾得死去活来,上网电价甚至比火电还便宜,根本不用靠补贴过日子。 正是因为核电这么关键,它早成了中美AI竞赛里藏在背后的胜负手,可两国走的路真是天差地别。 先说说美国,他们的民用核电简直是停滞不前,好多核电机组都老旧了,新建项目更是难上加难,审批流程能拖好几年。 更要命的是,美国的电网还是上世纪70年代建的老底子,根本扛不住AI数据中心的“电老虎”。 现在美国的数据中心已经占了全国2.5%的电量,差不多等于一个纽约市的用量,波士顿咨询预测,到2030年AI数据中心的负荷容量能到45吉瓦以上。 谷歌、亚马逊这些巨头急得像热锅上的蚂蚁,谷歌要是把搜索全换成AI,一年耗电量能赶上爱尔兰整个国家,他们只能到处找电网有富余的地方抢电,谁先签下供电合同谁就占了先机。 亚马逊干脆花6.5亿美元建核动力数据中心园区,Meta投8亿在印第安纳州建的数据中心,能不能满负荷运转还得看电网脸色,这哪是搞AI竞赛,分明是先忙着“抢电大战”。 高盛都警告了,数据中心的能源需求已经快超过电网升级的速度,成了AI发展的关键瓶颈,到2027年美国40%的数据中心可能都要电力不足。 再看咱们中国,路子完全不一样,早就把核电当成了清洁能源的“压舱石”,步子稳又快,国家“十五五”规划明明白白说了,要积极安全有序发展核电,到2029年装机容量要从现在的5800万千瓦翻一倍,冲到1.2亿千瓦。 更关键的是,咱们的核电技术完全是自己的,“华龙一号”“国和一号”都是自主研发的三代技术,安全性达到国际最高水平,发电效率超过45%,还能出口到巴基斯坦,这技术硬实力摆在这。 而且咱们的核电成本控制得特别好,经营现金流常年超400亿,手里握着600多亿现金,根本不愁没钱建项目。 你想想,数据中心需要多少电,咱们的核电站就能稳定供多少,不像美国那样看天吃饭、靠抢电过日子。 2024年咱们的数据中心耗电量已经到2500亿度了,这还只是开始,但有核电撑着,根本不用犯愁电力跟不上算力的步子。 说白了,AI竞赛表面上是比谁的模型更聪明、算力更强,骨子里其实是比谁的能源能撑得住。 美国那边科技巨头再有钱、技术再先进,没有稳定的电力供应,再好的AI计划也得卡壳。 马斯克天天喊缺电,不是他想制造焦虑,是他真的看到了问题的严重性——电网跟不上,AI就是无源之水。 而咱们中国早就看清了这一点,把核电这块能源基石打牢了,AI发展自然有源源不断的动力。 这可不是空谈,是实打实的布局和成果摆在那,未来AI竞赛的输赢,从能源这步棋上就能看出端倪。