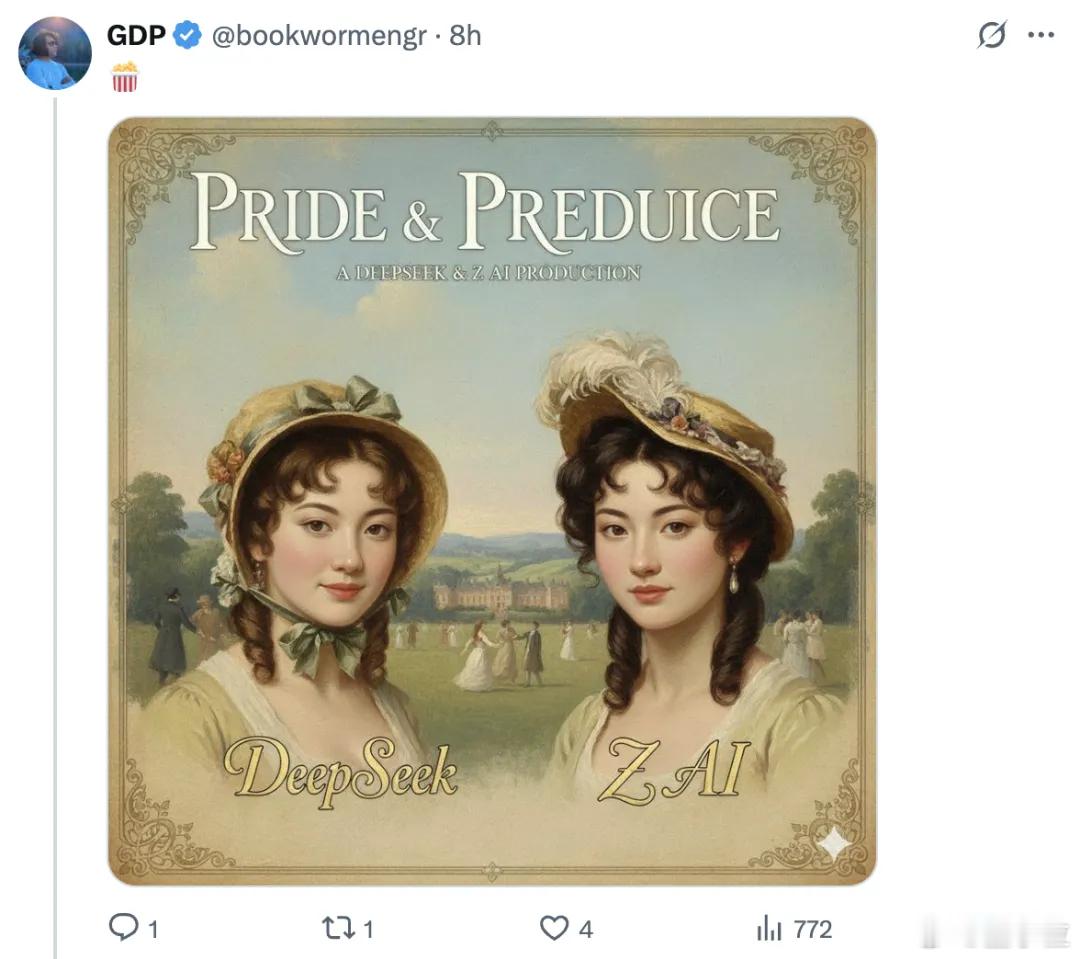

智谱和DeepSeek撞论文了AI视觉Token大战撞车

刚发论文就撞车,智谱和DeepSeek这回在视觉Token方案上正面打了个照面。

前者刚开源Glyph,后者OCR方案还在热搜。两家都盯上了一个目标——用图像压缩文本Token,让大模型吃下更多内容、更省算力。

大模型能力是猛,但上下文太长一直是块难啃的骨头。

原来50K的上下文窗口想翻倍到100K,算力直接飙到4倍,关键是,效果未必更好。

信息太杂,模型不但不聪明,反而更迷糊。

所以这两年主要有3类解决方案:

- 拓展位置编码,但推理成本不降

- 优化注意力机制,速度快但Token还在

- 上RAG走检索,快是快,质量难说

先看智谱这边,这次选择了“看图说话”:

- 把长文本排版成图片当成输入

- 用视觉大模型一次性读完,不用Token拆碎再拼

- 同样长度的输入下,能看内容更多,还能理解整体结构

比如一部《简·爱》文本版本要240K Token,视觉形式只用80K视觉Token就能看完。

而DeepSeek靠OCR压缩Token,同样方向、不同路径:

- OCR更贴近真实文档解析场景

- Glyph更偏学术范式实验+训练体系完整设计

但从底层逻辑来看,两者都在试图把“像素”当作未来AI的基本单元。

卡帕西早就喊过:像素天然比文本更适合作为LLM输入。信息密度高、内容类型全、形式也灵活。

换句话说,文本是人类给机器的适配方案,而视觉输入,才更像AI自己“看世界”的方式。

这场撞车,也许是下一代AI范式切换的信号。