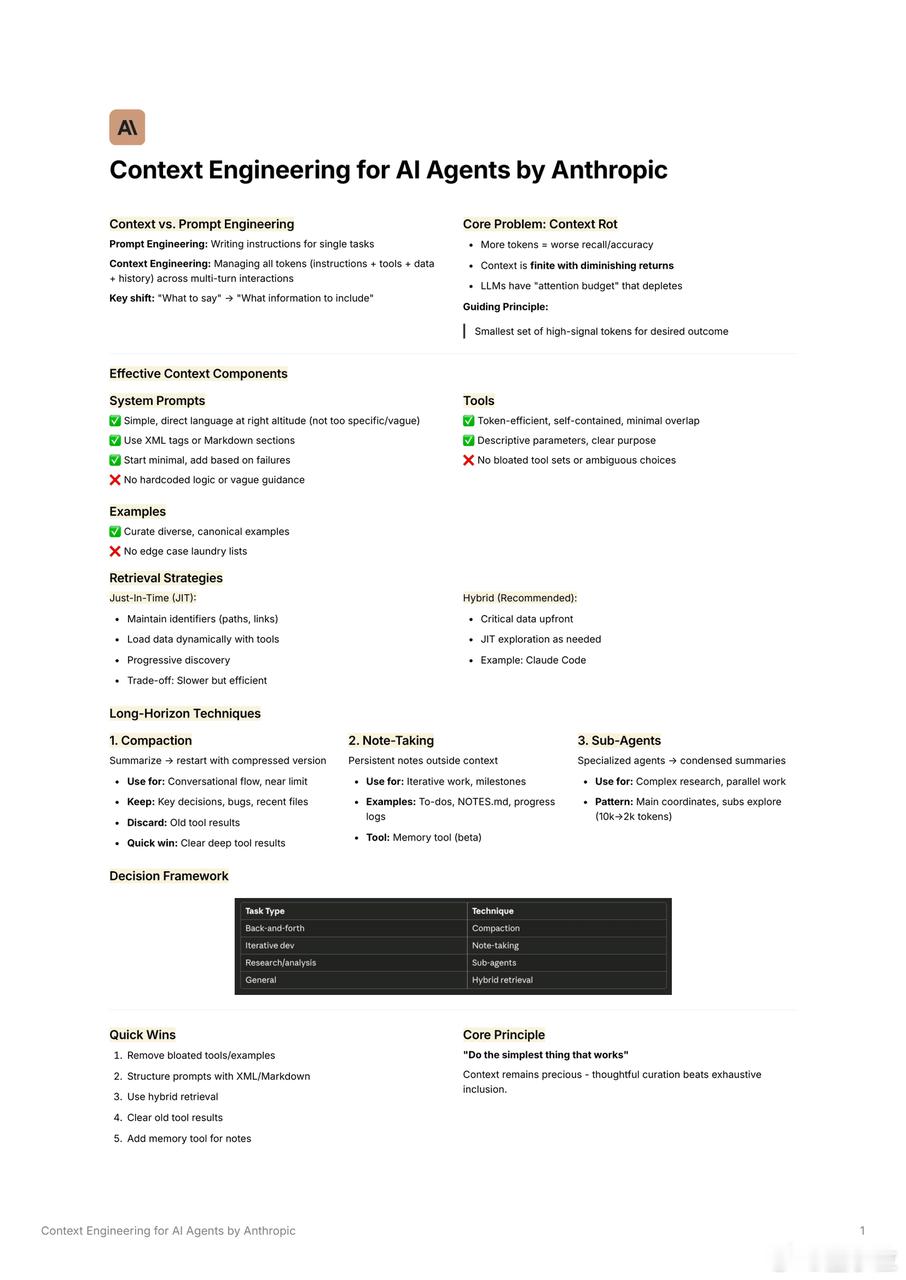

上下文工程少即是多精准投喂AI有诀窍

上下文工程,是怎么设计整个上下文系统,让AI能在多轮交互里持续完成任务的艺术。

而这篇指南,提到的一大转变是:“告诉AI说什么” → “只给它需要知道的信息”。

以下是几个核心要点:

一、信息越多越错

上下文是稀缺资源,大模型有“注意力预算”,信息越多越容易漂移、失焦、性能下降。核心原则是:

用最少的高信号token,换取你想要的结果。

二、有效上下文结构长这样:

- 系统提示词要简洁明了,不要模糊废话

- 用XML或Markdown结构标信息

- 从最小可用集开始设计,失败后再加

- 工具调用要少而精,参数清晰,不要堆用不上的API

- 示例选经典即可,无需搞“案例大合集”

三、长任务怎么搞?Anthropic推荐三种方法:

1)Compaction(压缩)

阶段性总结关键点,重启上下文,用精简内容继续对话

适合:有来回、上下文超限的任务

2)Note-Taking(记笔记)

让Agent把关键进展、TODO写进上下文外的“持久笔记”

适合:长期任务、阶段性Milestone

3)Sub-Agents(子Agent)

主Agent下发子任务,子Agent返回总结,主Agent负责协调整合

适合:复杂研究、多线程并行任务

四、检索策略推荐用Hybrid

关键数据先给,次要信息用Just-in-Time方式动态加载

例如:Claude Code就是这么干的

五、适配不同任务的技巧推荐:

- 问答类 → 用压缩(Compaction)

- 迭代开发 → 用笔记(Note-Taking)

- 调研分析 → 用子Agent(Sub-Agents)

- 通用工作流 → 用混合检索(Hybrid Retrieval)

六、五个立刻能改进的点:

1)去掉用不到的工具和示例

2)用结构化标记组织上下文

3)用Hybrid方式加载信息

4)定期清理旧工具调用结果

5)加入“笔记工具”保存长线内容

上下文工程并非塞一堆冗余信息,而是精准控制“给多少、给什么、什么时候给”。

![陈震这不是没看法,估计AI也挑不出理[doge]](http://image.uczzd.cn/11409113866734593322.jpg?id=0)