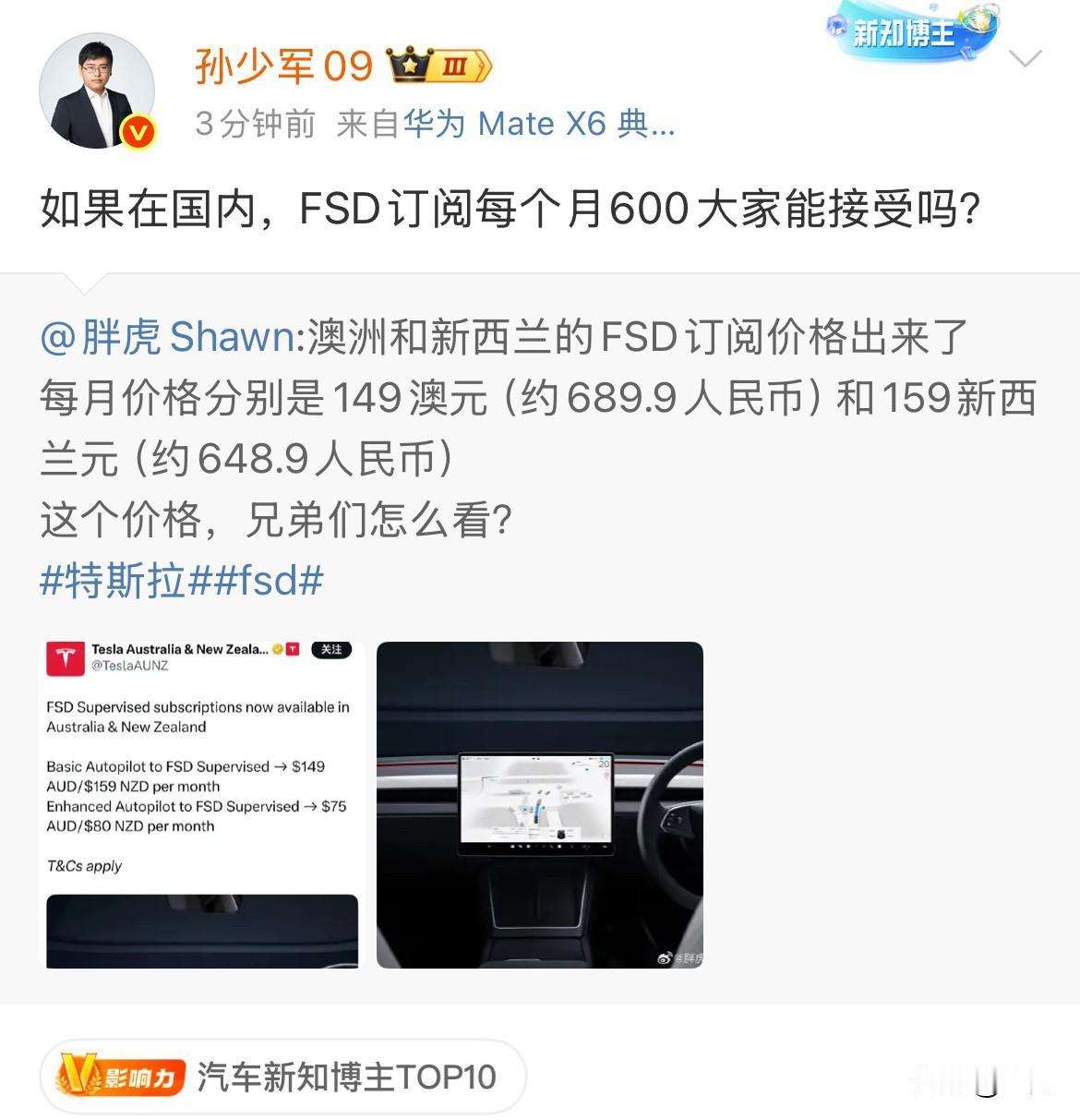

最近车圈里又是风波不断,美国国家公路交通安全管理局突然对特斯拉的FSD全自动驾驶系统展开了正式调查,原因是在他们统计的58起事故中,有6起涉及特斯拉在开启FSD状态下闯红灯并与其他车辆发生碰撞。听起来挺吓人的,但仔细想想,事情可能并不像表面看起来那样严重。

根据公开信息,目前特斯拉在美国的保有量已经超过290万辆,而涉及FSD的事故一共58起,换算下来平均每万辆车年事故率仅为0.2起。 相比之下,美国人类驾驶员每年平均事故率大概在每万辆车3起左右。而且NHTSA自己也承认,这些事件中并没有造成人员死亡,受伤情况也属轻微。 除了特斯拉,Waymo的无人出租车在过去一年里其实也发生过17起事故,但它的运营规模小得多——只有约1500辆车在路上跑。

再看国内,比如小鹏、蔚来的辅助驾驶系统也都出现过类似被监管关注的情况,尤其是在识别特殊交通标志、施工路段时都曾引发过讨论。 但其实问题根本不在技术本身,而在于人们的认知框架。监管机构往往沿用传统汽车的管理思维来看待自动驾驶,一旦出事就试图“一刀切”限制功能。 而实际上,AI驾驶和人类驾驶的失误逻辑完全不同。人类犯错常常是因为疲劳、分心、情绪化,而AI犯错更多是数据偏差或罕见场景应对不足。

而且社会舆论对机器失误的容忍度远低于人类,一起自动驾驶事故可能登上头条,而每天成千上万起人为事故却被视为常态。 在我看来,这次调查反而凸显了特斯拉技术路线的先进性。他们采用的是“模仿学习”策略,让AI通过海量人类驾驶数据学习开车,好处是行为拟人、适应力强,但缺点就是连人类的坏习惯也一并学了——比如偶尔抢灯、压实线。 而Waymo走的则是“规则预设+高精地图”的保守路线,虽然守规矩但缺乏应变能力,遇到修路或者交警指挥直接懵圈。长期来看,特斯拉这种以数据驱动、持续进化的模式明显更适合复杂多变的真实路况。

但监管却往往更青睐Waymo那种“不出错但也不进化”的策略,这实际上是一种避责思维,而不是推动行业进步的思路。 事实上,类似的情况在科技史上并不少见。当年汽车刚出现时,欧美都出台过“红旗法”,要求一辆车必须配一个人在车前摇旗提醒,以免惊吓马匹,你看,用旧框架管理新技术多么可笑。

如今监管最该做的不是纠结于零事故,而是建立一套允许试错、数据共享的责任认定机制。比如设立自动驾驶黑匣子标准、构建路测数据开放平台,甚至推行No-fault责任险。特斯拉自己也该加快数据清洗,过滤掉那些危险驾驶行为,不能让AI好的坏的全学。 说到底,这次调查与其说是特斯拉的危机,不如说是整个自动驾驶行业走向成熟的必经阶段。

尤其是中国车企,咱们这的路况才是自动驾驶的终极考场,各种奇葩标线、混合交通、突然出现的行人电动车……谁能在这做好,谁就能在未来的无人出租市场中站稳脚跟。 希望这次风波之后,监管更能听懂技术的声音,而企业也更懂得如何与规则共舞。