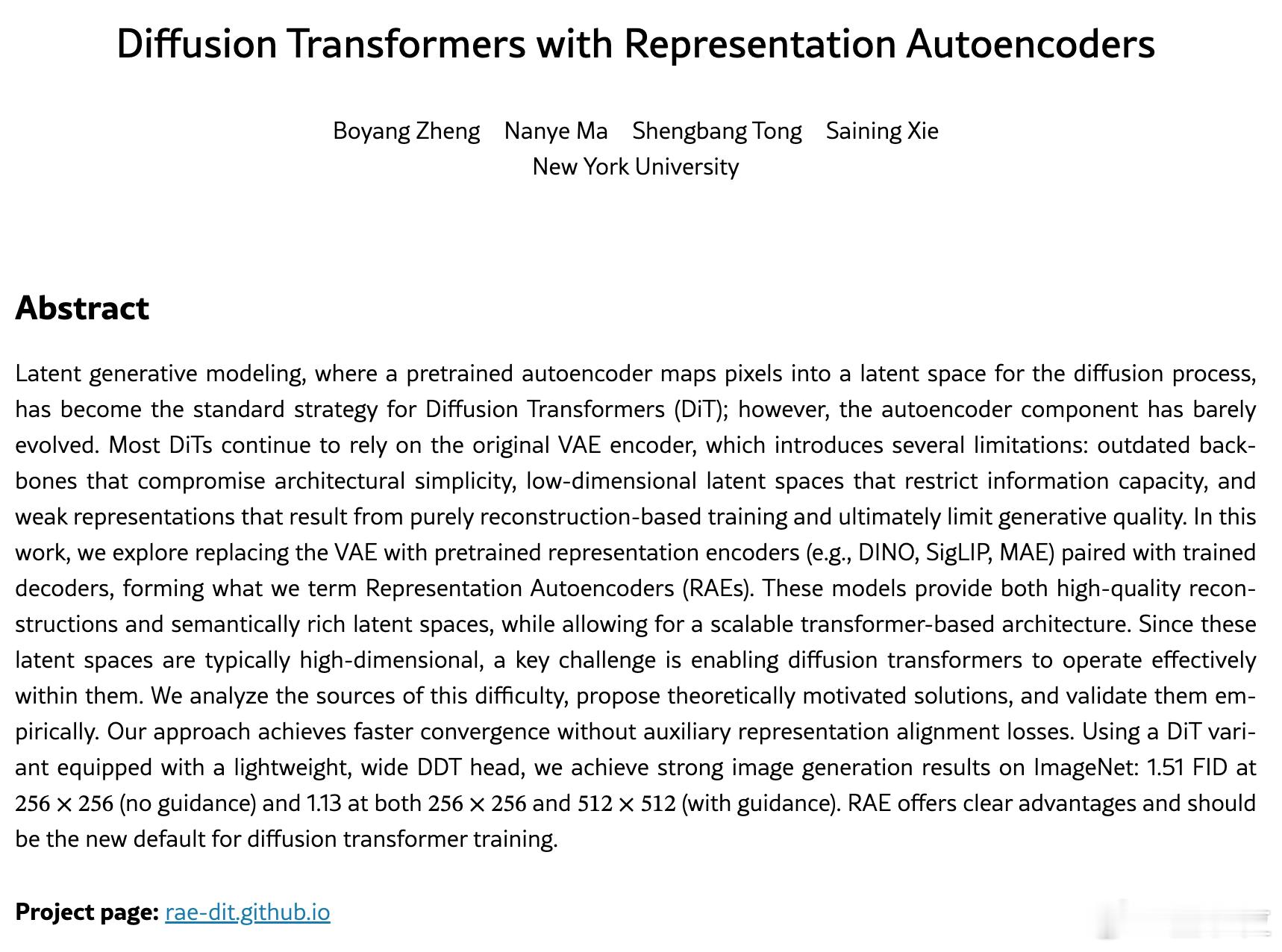

谢赛宁团队换代VAE谢赛宁团队发布扩散模型新架构

昔日扩散模型的“老大哥”VAE,或许真的要退役了。

谢赛宁团队最新研究提出了RAE(Representation Autoencoders)架构,用来替代VAE在扩散Transformer里的位置。

RAE最大的不同在于:它不再从头训练编码器,而是直接用现成的预训练表征模型(比如DINO、SigLIP、MAE)+一个轻量级解码器,整个结构更简单、重建更清晰、收敛更快。

突破点如下:

- 结构更轻量:RAE用ViT-B等编码器,只需22 GFLOPs,而VAE动辄450 GFLOPs;

- 信息更丰富:VAE潜空间只有4通道,RAE能保留更完整的视觉语义;

- 训练更高效:RAE无需辅助损失或对齐过程,解码器直接用L1+LPIPS+GAN损失搞定;

- 生成更强大:RAE搭配的DiT模型,FID分数做到256分辨率下1.51(无引导)、1.13(有引导),已超REPA。

值得一提的是,谢赛宁起初也以为:这类表征编码器虽然语义好,但细节损失多,不适合生成模型。结果是,他自己打脸了。

而RAE要在高维潜空间搞扩散,听起来很难,但他们只用了三步简单适配就做到了:

1. 调大Transformer宽度:宽度必须不小于潜空间维度,否则模型连过拟合都做不到;

2. 调整噪声调度:适配高维输入;

3. 训练时加点噪声:提高解码器鲁棒性,对轻微误差更宽容。

再加上轻量化的“宽浅”扩散头部设计,最终模型DiTDH在训练效率和生成质量上全面超越基于VAE的旧架构,训练收敛速度快了16倍。

论文链接:arxiv.org/abs/2510.11690

项目主页:/rae-dit.github.io/