[LG]《Learning to Reason as Action Abstractions with Scalable Mid-Training RL》S Zhang, D Yu, Y Feng, B Jin... [Apple] (2025)

《Learning to Reason as Action Abstractions with Scalable Mid-Training RL》

🔍 研究背景:

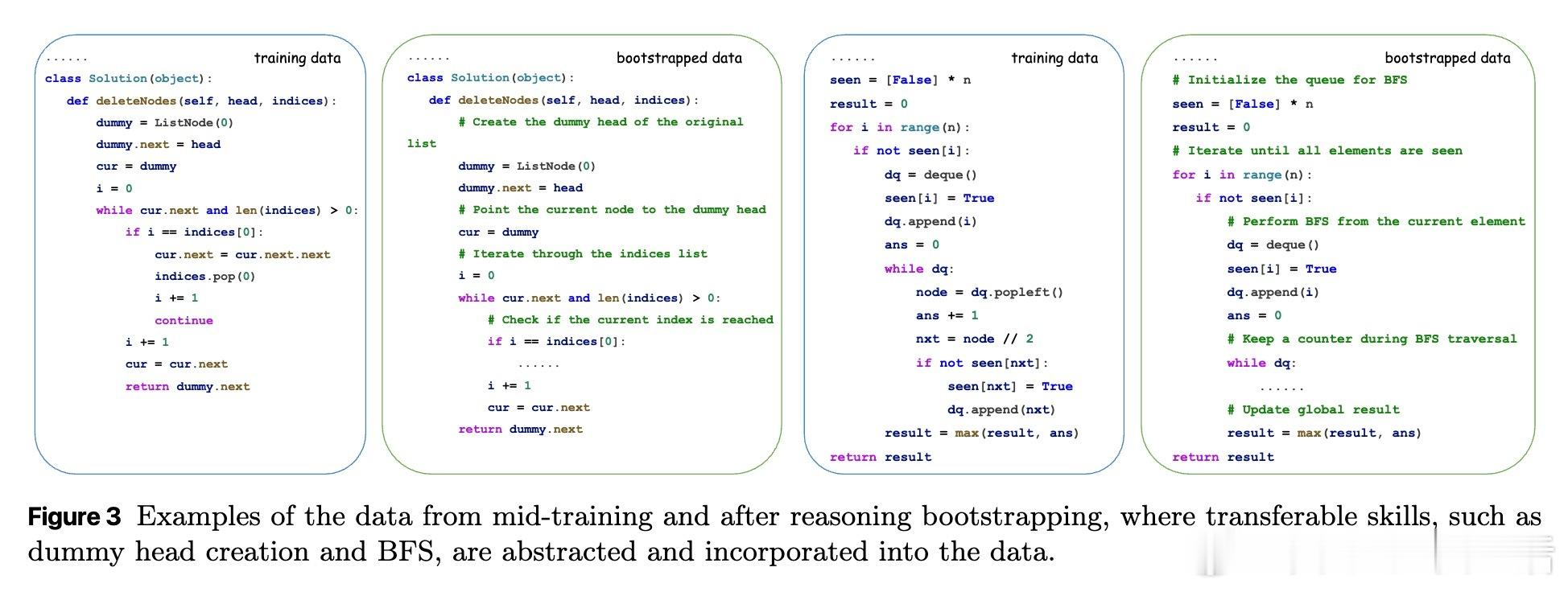

大型语言模型(LLMs)结合强化学习(RL)表现卓越,尤其在代码生成、数学推理等任务中。但要充分发挥RL潜力,关键在于“中期训练”(mid-training)阶段——通过专家示范数据提炼紧凑有效的动作子空间,为后续RL奠定坚实基础。

✨ 核心贡献:

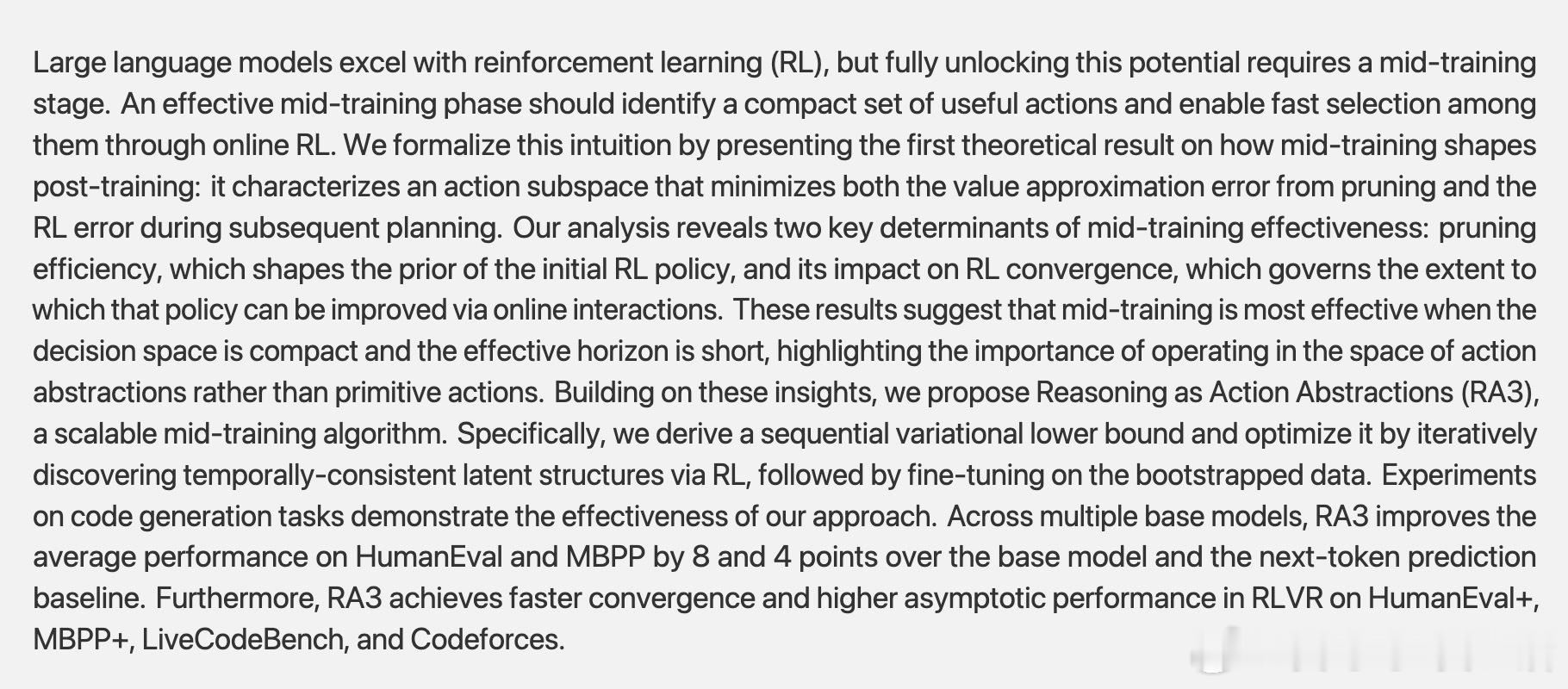

1️⃣ 首次理论分析中期训练如何影响后期RL,明确中期训练目标是找到一个动作子空间,使得动作剪枝误差和后期RL误差均最小化。

2️⃣ 揭示两大关键因素:动作剪枝效率决定初始策略先验,动作时序延展性影响RL收敛速度。

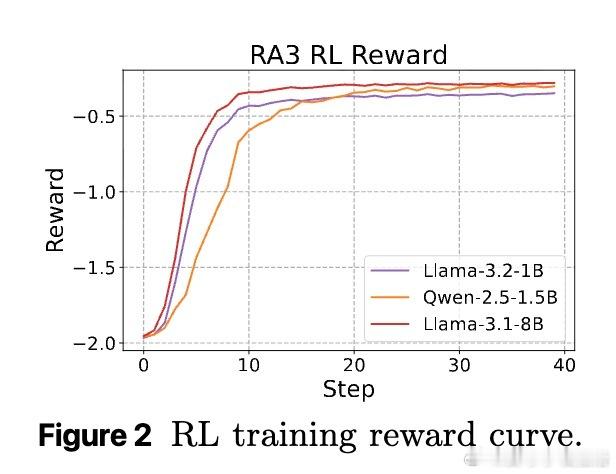

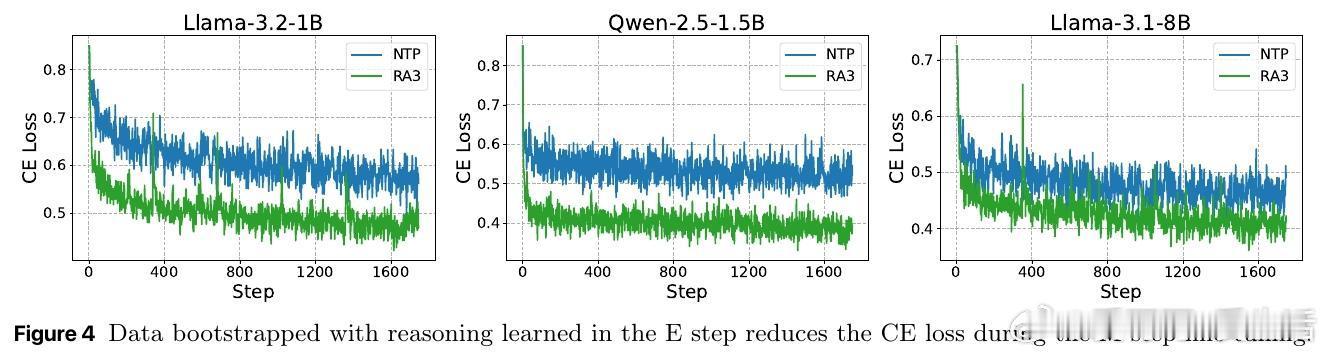

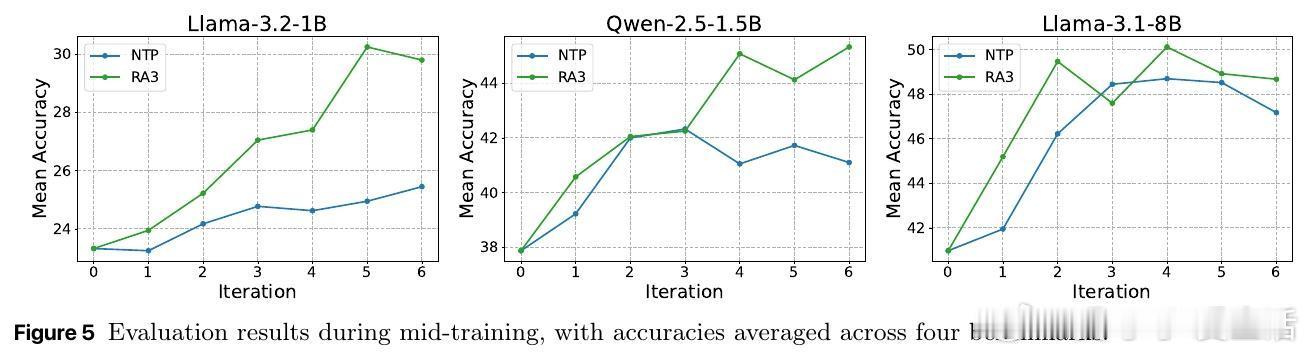

3️⃣ 提出RA3算法——基于时序变分下界的可扩展中期训练方法,结合自监督RL发现时间一致的潜变量(行动抽象),并用引导数据进行微调。

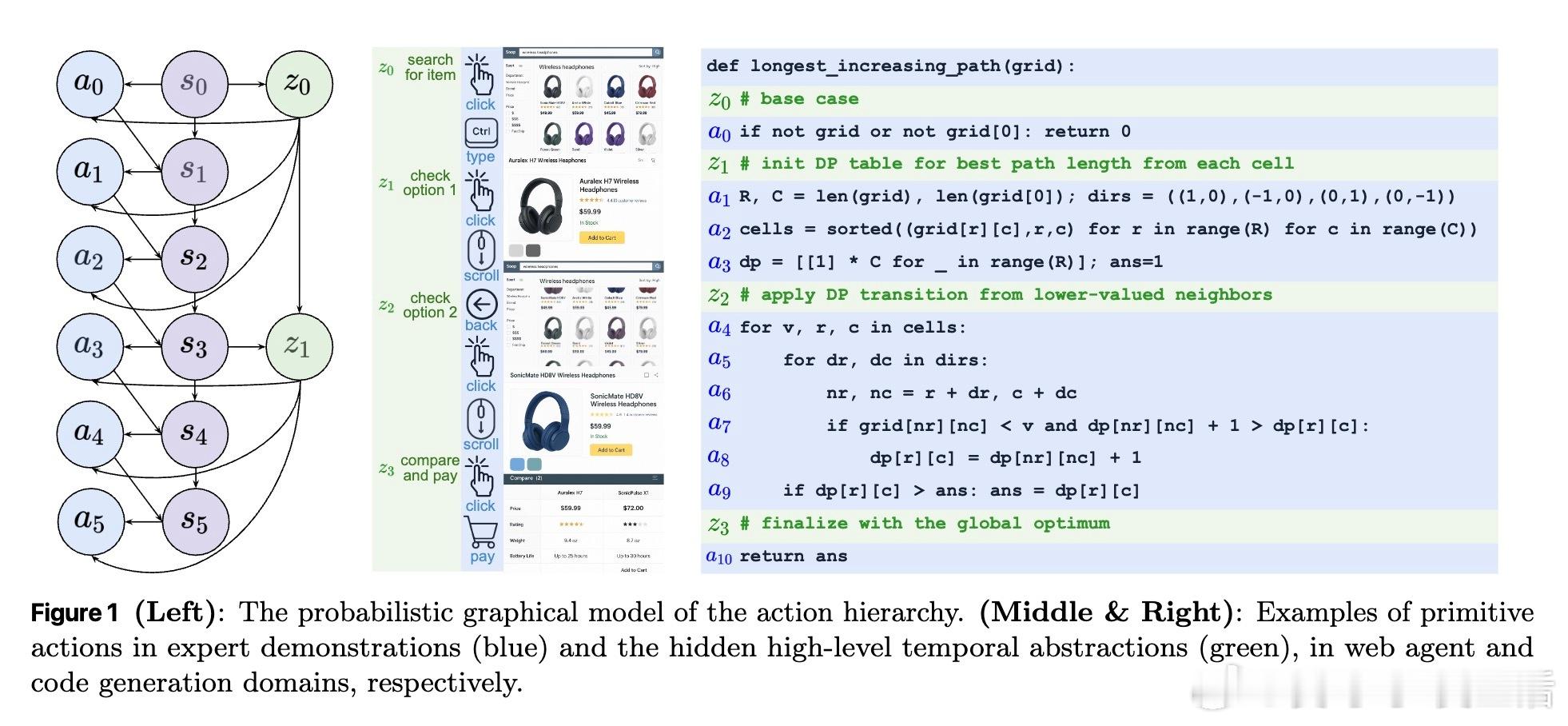

4️⃣ 实验验证RA3在Python代码生成任务上显著提升HumanEval、MBPP等基准表现,平均提升8分,同时加快RL收敛。

🔑 理论亮点:

- 动作抽象(如“思考-行动”分层结构)大幅减少有效动作集大小,提升剪枝效率,降低所需专家示范数量。

- 时序动作抽象缩短有效规划时长,加快价值迭代式RL收敛,提升样本效率。

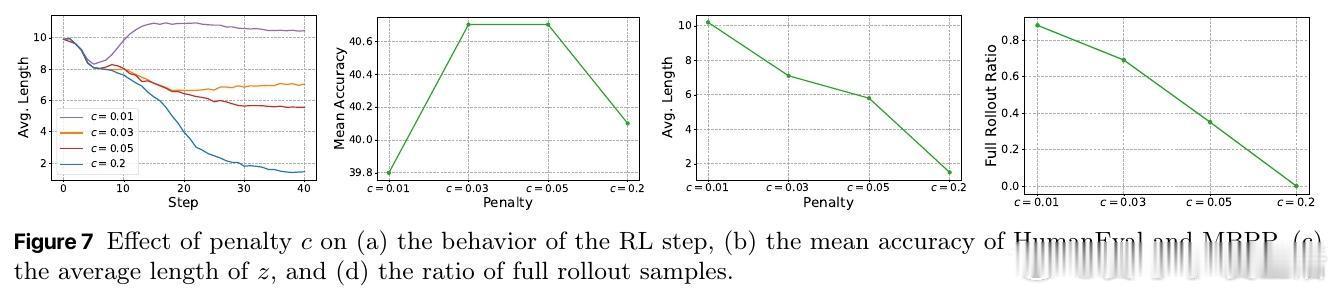

- KL正则项设计引导模型仅在必要时生成“思考”动作,控制计算成本。

🚀 实践意义:

- RA3让模型自动学会“合理推理”作为抽象动作,提升策略泛化能力。

- 结合高质量互联网代码数据,RA3无需昂贵的人工推理标注即可规模化应用。

- 中期训练优化后,后期RL能更快更好地提升模型性能。

💡 思考:

本工作从理论到实践,为中期训练设计提供了清晰准则和算法框架,强调“动作抽象”在语言模型强化学习中的关键地位。未来可探索更丰富的动作层次结构及跨任务通用性,进一步推动LLM的智能推理与决策能力。

📄 详细阅读请见:

arxiv.org/abs/2509.25810

强化学习 大语言模型 中期训练 动作抽象 代码生成 RA3算法 机器学习理论