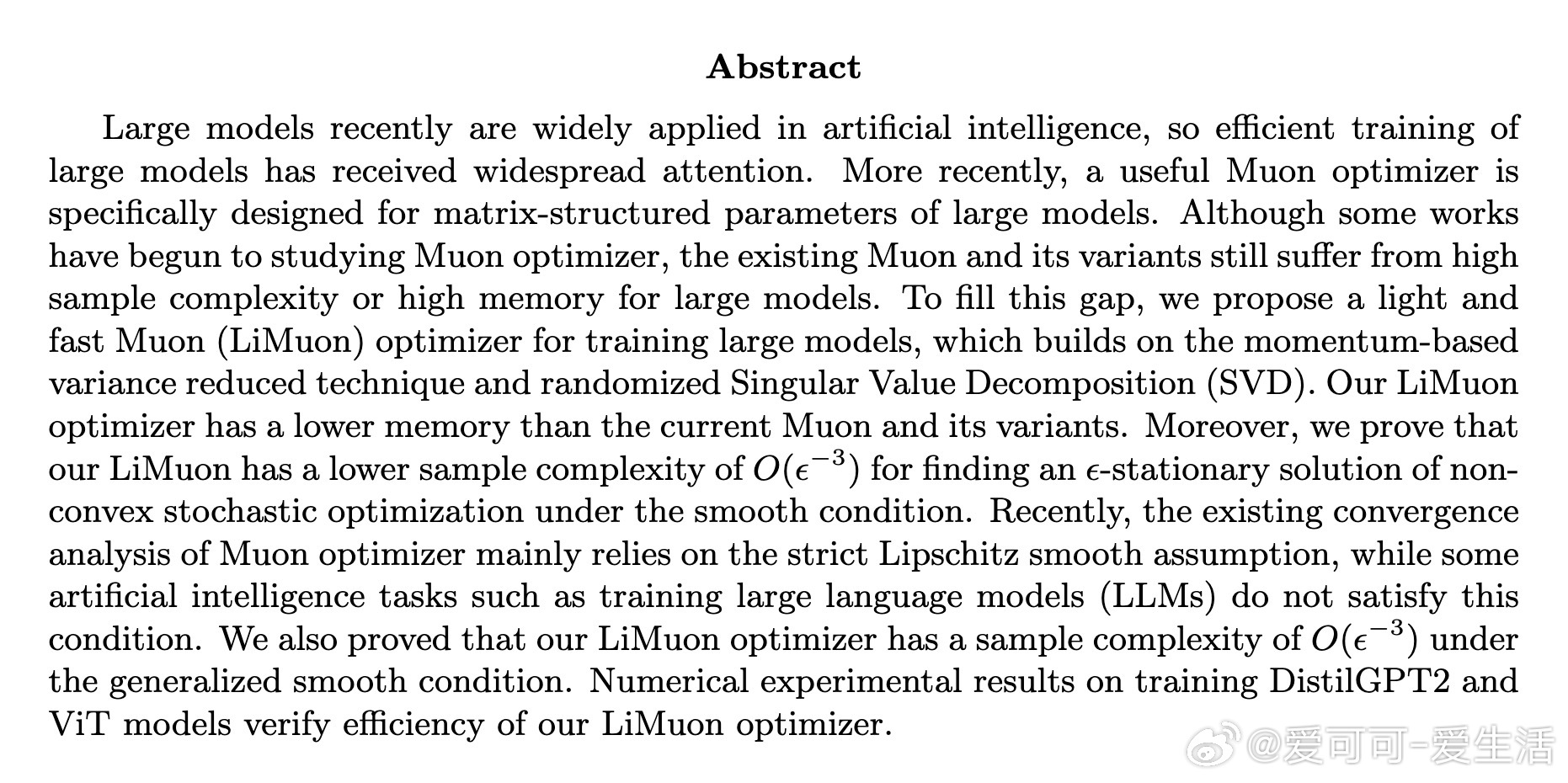

[LG]《LiMuon: Light and Fast Muon Optimizer for Large Models》F Huang, Y Luo, S Chen [Nanjing University of Aeronautics and Astronautics] (2025)

LiMuon:轻量快速的Muon优化器,专为大规模矩阵参数模型设计,显著降低训练大模型的内存和样本复杂度。

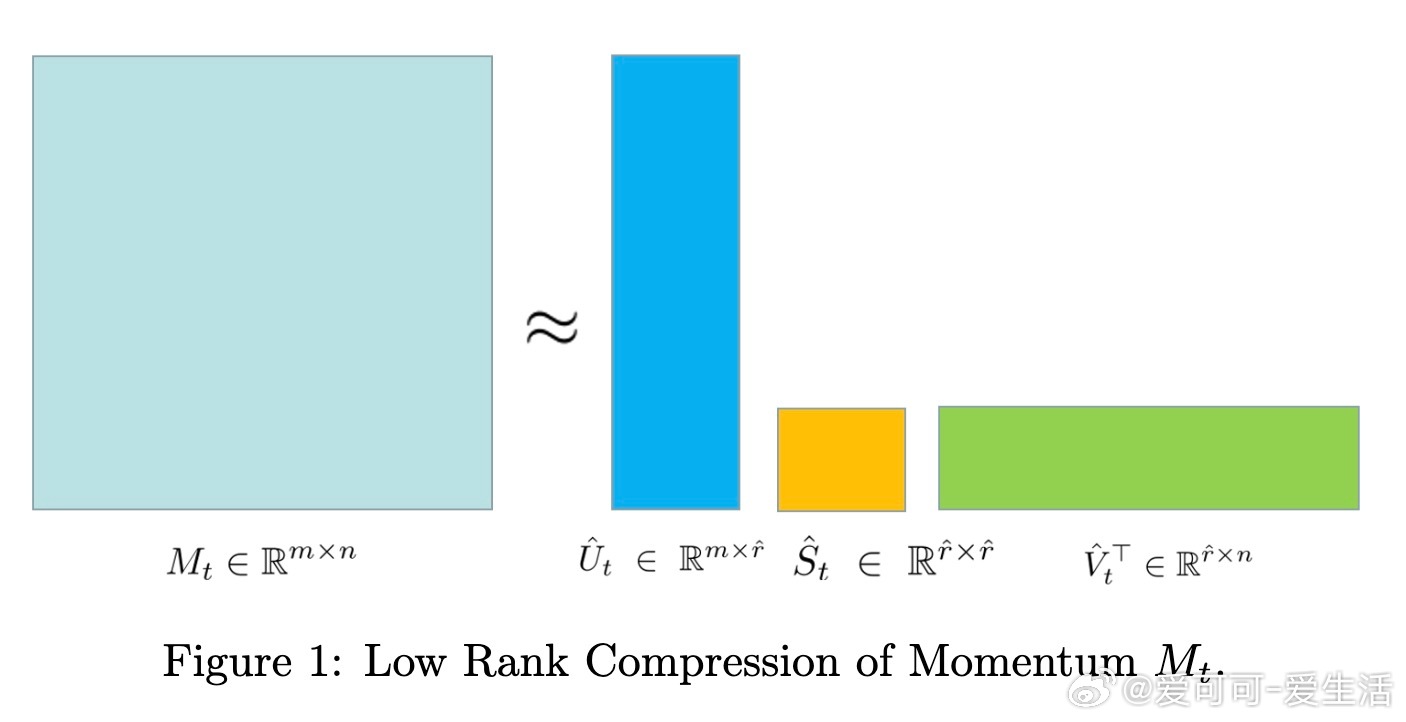

• 结合动量基的方差缩减技术与随机奇异值分解(RSVD),实现对梯度矩阵的低秩近似,节省状态内存。

• 理论证明:在非凸随机优化中,LiMuon在一般光滑条件下达到ε-驻点的样本复杂度为O(ε⁻³),优于现有Muon及其变体的O(ε⁻⁴)。

• 支持两种方案:Option 1使用完整梯度估计,内存较高但计算直接;Option 2采用RSVD压缩梯度估计,显著降低内存,适合超大模型。

• 适用更宽松的广义光滑假设,突破传统Muon依赖严格Lipschitz光滑条件的限制,适配训练大型语言模型(LLMs)等更复杂场景。

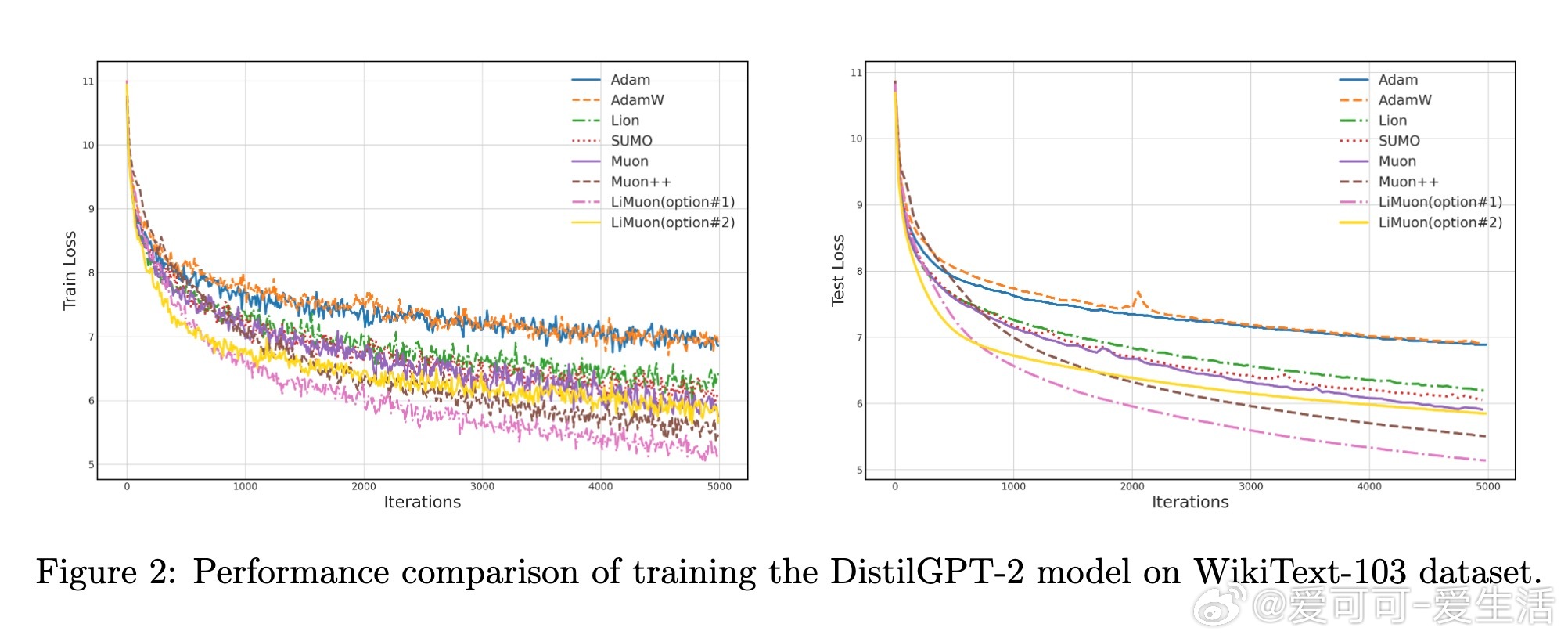

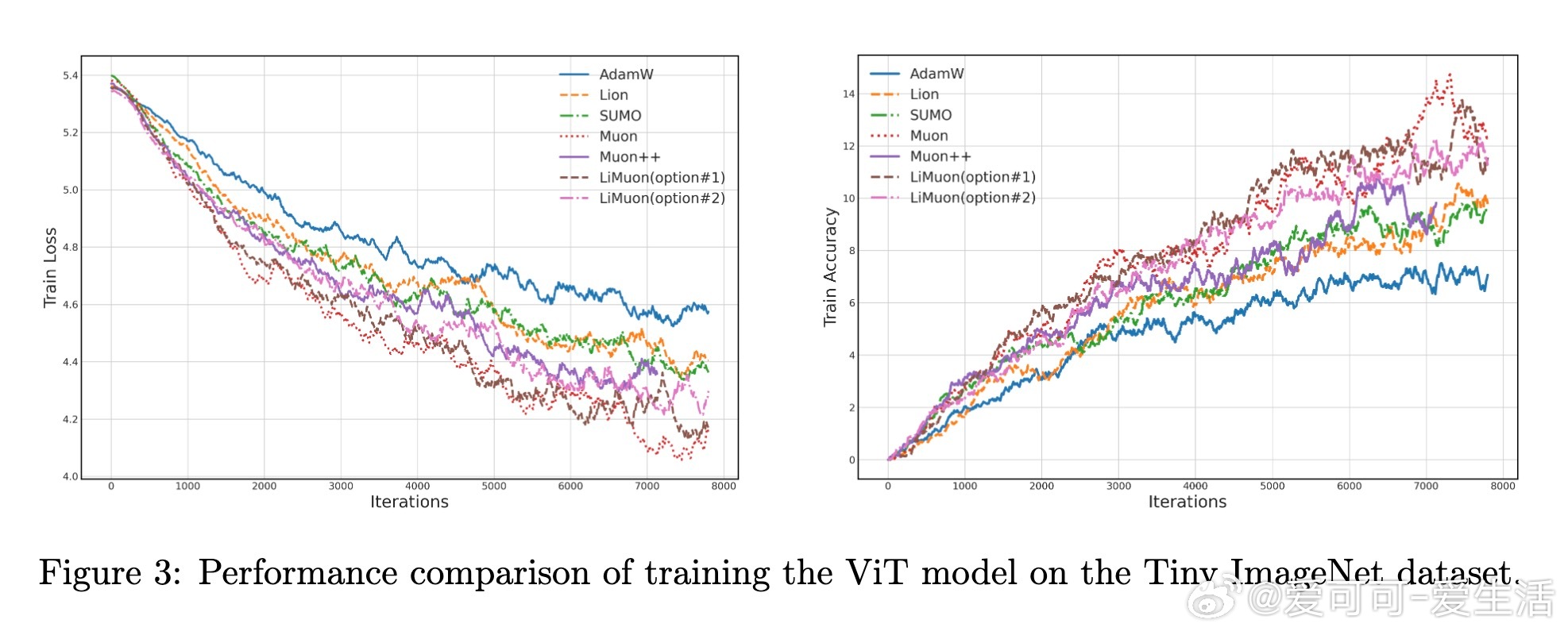

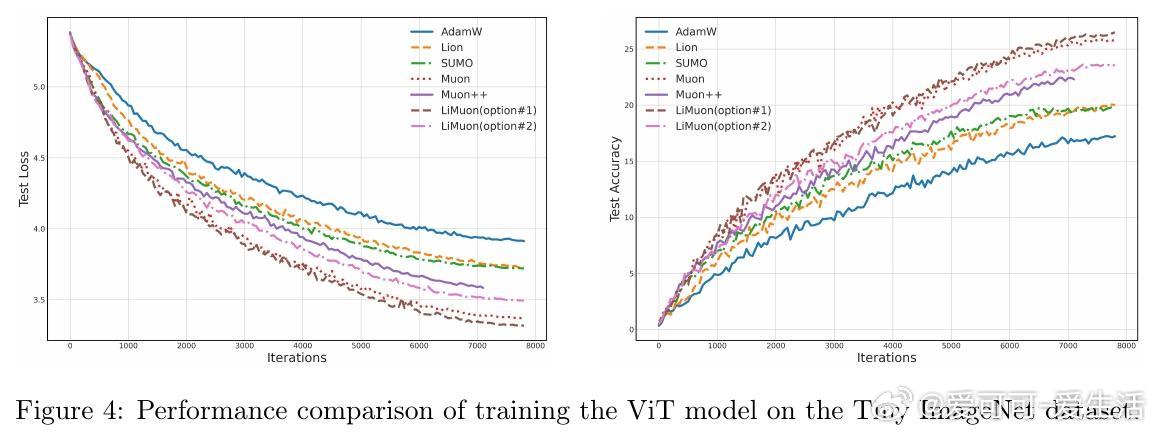

• 数值实验验证:在DistilGPT2和ViT模型训练中,LiMuon相较AdamW、Lion、Muon++和SUMO表现出更快收敛速度和更低内存占用,尤其Option 2在内存效率上优势明显。

• 训练细节:DistilGPT2在WikiText-103数据集上,LiMuon(1)实现最优困惑度,LiMuon(2)在节省6.05GB内存的同时仍保持优异性能;ViT模型训练同样体现了高效性与稳定性。

• 新颖收敛分析框架,区别于基于Frank-Wolfe方法的Muon++和GGNC,保持Muon迭代结构同时获得更优理论保证。

心得:

1. 利用低秩矩阵近似显著缓解大模型训练的内存瓶颈,为大规模参数优化提供新思路。

2. 在更宽松的光滑性假设下依然保证收敛,拓宽了大型模型优化器的适用范围。

3. 结合动量方差缩减和随机SVD的设计,有效平衡计算效率与内存消耗,兼顾性能与资源限制。

详情🔗arxiv.org/abs/2509.14562

大模型训练优化算法低秩矩阵随机奇异值分解非凸优化深度学习人工智能

![WS-21的模型来了[鼓掌]3711结构,加力改成环形内喷+加大风扇压比,选用](http://image.uczzd.cn/15942295075296308956.jpg?id=0)